システム製作実験(藤波研担当分)

藤波研究室では,2009年度からシステム製作実験(3年後期)を担当しています.毎年,「現実世界の情報を利用したコンピュータの新しい使い方を考え出す」ことを統一テーマとして個々のテーマを設定しています.特に成果発表会を意識して,デモストーリーや見栄え,完成度の高さに注意して開発しており,毎年,発表会参加者から高く評価されています.

以下では,これまでの成果を簡単に説明します.研究室での研究テーマなどは〔こちら〕から.

2015年度

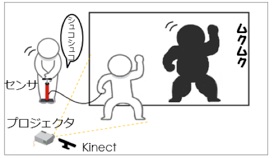

テーマ1:デプシス:ポンプを使った人の影の風船化

本テーマでは,本来厳密に1対1に存在ししている物体(人)と影の関係を拡張し,影と相互作用(インタラクション)できるシステム(デプシス)を実現することを目指しました.つまり,見た目は人の影ですが,一部はコンピュータが作り出した仮想の影で,ホースをもった体験者(影を作り出す人)に別の人がホースに繋がったポンプに空気を注入するとそれに合わせて影を膨らませることが出来ます.人の体の周辺に仮想の影をマッピングするために深度カメラ(Kinect)を用いて骨格検出を行い,空気ポンプの注入状況を測るためにホース内にマイクロホンを設置しています.ポンプの動きという実世界の動きが仮想の影に反映され,それがポンプを動かす人に影響を与えるという点で,実世界と仮想世界の相互作用を実現した例です.

(a) システムの最上位レベルの構成要素 (b) 利用風景 (c) ポンプ状態の取得

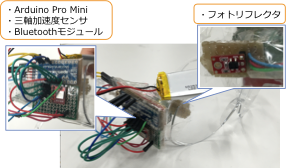

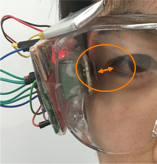

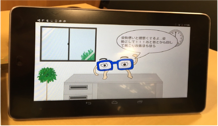

テーマ2:めがねくん:メガネデバイスを用いたデスクワーク中の健康管理システム

本テーマでは,眼鏡型デバイス(めがねくん)によりデスクワーク中の健康状態管理を自然な状態で可能にすることを目指しました.化学実験用ゴーグルに,瞬きを計測するためのまぶたの動きに伴う距離変化を検出するフォトリフレクタと,頭部の動きを検出するための3軸加速度センサ,制御用の超小型Arduino(Pro mini),スマートフォンとの連携のためのBluetoothモジュールを搭載しており,眼鏡単体で計測が可能です.検出した瞬きや頭部の動き情報はスマートフォンに送信され,仮想のキャラクタ(めがねくん)が利用者に休憩や首を回して凝りを和らげることを促すメッセージを出します.

2014年度

テーマ1:P.M.P:ジェスチャ認識を用いたプレゼン支援機能

本テーマでは,身振り手振りでスライドプレゼンテーション最中のスライド送りを制御することを目指しました.深度センサ(Kinect)により発表者の骨格情報を取得し,特定のジェスチャを骨格状態の遷移から認識します.そして,画像の集合で表されたプレゼンテーションを進ませたり戻したりします.また,スライド中の3次元モデルを回転させたり拡大縮小させたりして説明するために,Unityを用いて3次元モデルの操作を実現しました.

(a) プレゼン画面 (b) 操作の様子

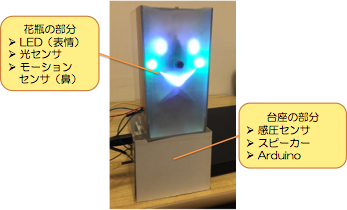

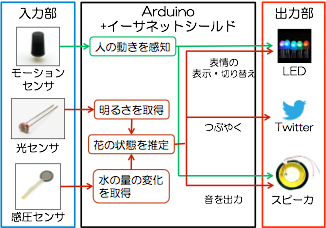

テーマ2:ポッとも:花の状態を通訳する花瓶

本テーマでは,Internet-of-Thingsの一例として, 花瓶に生けられている花に愛着を持ってもらうために, 花瓶が自身の状態をセンシングしてインターネット上の人間とコミュニケーションをするシステムを開発しました.光量や水量が十分でないと,花瓶はユーザが接近したときに震動したり表情を形成するよう配置されたLEDが点灯して通知し(実世界でのユーザとのインタラクション),Twitterを通じて自身の「心情」を呟きます(仮想世界でのインタラクション).このようにあ,デジタル化しTwitterというインフラに統合することで人とモノのコミュニケーションが成立します.システムは,ArduinoにEthernetシールドを搭載しているため,中継のPCなしにモノ単体で動作可能です.

(a) ハードウェア(LEDの点灯位置や色が花瓶の感情を表す) (b) システムの機能構成

(c) 表情(左:笑顔(水と光が十分), (d) つぶやきの例

中央:不機嫌1(水が不足),右:不機嫌2(水と光が不足))

2013年度

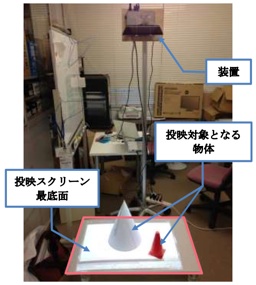

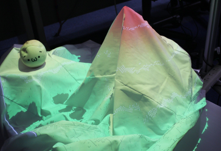

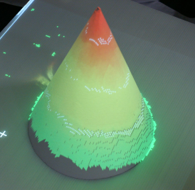

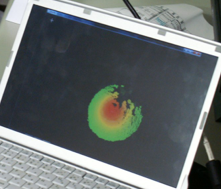

テーマ1:AURORA:物体形状に動的に対応した情報投影

本テーマでは,動的なプロジェクションマッピングを目指しました.東京駅に代表されるプロジェクションマッピングは事前の詳細な投影位置決めが重要となりますが,時間がかかる作業となるうえ,形状が時々刻々と変化する物体には対応することができません.本テーマでは,深度センサを用いて取得した物体形状の情報をもとに投影内容を変化させます.すなわち,高さに応じて投影する色を変化させます.また,プロジェクタの性質上,距離が離れるにつれて投影がそのサイズが大きくなり狙い通りの位置に指定した色を出力することが出来なくなるので,距離に応じて画素数を変化させています.

b) 深度センサとプロジェクタ c) 投影風景1

d) 投影風景2 e) 投影時の内部状態

テーマ2:諷ring:さりげなく伝える風鈴型警告器

本テーマでは,日常空間に浸透したモノを用いた情報伝達を目指しました.ネット上に存在する情報源(天気予報)とデバイスが存在する空間の状態(温度,湿度)をもとに警告内容を決定し,本物の風鈴の音や風鈴に設置されたLEDの色や点滅により,警告を伝達します.外部の制御用PCを必要とせずに,風鈴自体がネット上の情報取得,温度/湿度センサからのデータ取得・解析を行い,制御を行います.また,ユーザの詳細情報取得要求を考慮して,自動提供・手動取得という2段階のインタラクションを提供します.手動取得はユーザが風鈴の音や点滅の詳細を知りたい場合に,スマートフォンを通じて取得することを可能にするもので,風鈴自体の短冊に印刷されている2次元マーカー(QRコード)を端末で読み取り,風鈴へのアクセス情報を得て,端末のWebブラウザで詳細情報を閲覧します.風鈴にはArduinoが搭載されており,ミニWebサーバが搭載されています.また,風鈴の中の玉はモーターにつながっており,任意のタイミングで音を発生させることが出来ます.

a) 操作風景1 b) 操作風景2 c) 情報取得用マーカー d) Arduinoによるハードウェア

2012年度

テーマ1:エリオカート:仮想空間を走るラジコンカーの開発

本テーマでは,物理世界を走るラジコンカーと仮想空間が作り出す情報の融合を目指しました.システムは,ラジコンカーが走っている場所を認識して(便宜的にラジコンに視覚マーカーを貼付),プロジェクタを通じて仮想的な氷や悪路を作り出します.すると,それに応じてラジコンカーがユーザの操作とは別に振る舞いを変えます(例:スピンする,コース外に出ようとすると止まる).ラジコンカーとしては,赤外線リモコンで制御できる「チョロQハイブリッド」を用いており,前進・後退・停止・左右の操縦に必要なリモコンコードを学習することで,自作のプログラムからコントロールできるようになっています.

a)システム全景 b) コースの様子 c) ラジコンとマーカ d) コントローラUI

(プロジェクタ+カメラ) (水たまりや障害物が動的に投影されて出現) (Android携帯に実装)

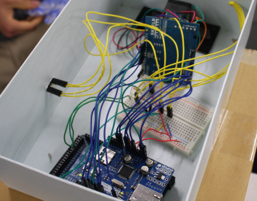

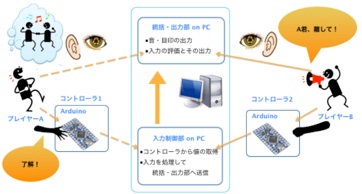

テーマ2:T to T:協調型音楽ゲームのための入力装置の開発

本テーマでは,プレイを通じて他者とのコミュニケーションを深めることができるようなゲーム用入力インタフェースの開発を目指しました.特に,音感リズムゲームと呼ばれるジャンルを対象としました.具体的には,1)ゲーム中に声を掛け合うなど,協力あるいは共同でタスクをこなさなければならない要素を導入することで「協調性」を発揮できるようにすること,2)協力あるいは共同でタスクをこなすことで達成感や難易の感想を共有することで,ゲーム後のコミュニケーションを活性化するようにすること,をポイントとしました.右図にあるような筒状のデバイスにはそれぞれ3カ所に「握り」を検知するセンサを取り付けてあり,どこを握っているかを把握することができます.画面に出される指示に従い2人のプレイヤが棒を握ります.

a) システム構成要素 b) 入力装置全体像 c)センサデータ処理部

2011年度

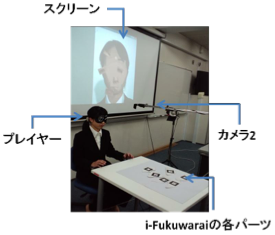

テーマ1:i-Fukuwarai: 伝統的な遊びの拡張

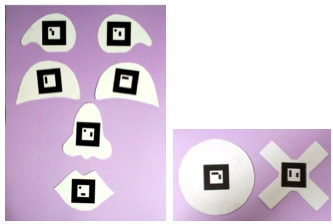

本テーマでは,「デジタルな遊び(ビデオゲームなど)」と「アナログな遊び(伝統的な遊び)」 の 2 つの遊びの形態を融合した,どの世代でも楽しめるようなツールを開発することで,あらゆる 世代の人でも楽しみつつ世代を越えたコミュニケーションを取ることを目指しました.本システムの特徴は,自分自身の顔の画像(またはあらかじめ用意した任意の顔画像)を用いて福笑いをすることができる点にあります.通常の福笑いに見られる紙のパーツを手で配置する際の手触りを残すことを重視して,a)のような各パーツを用意してあります.パーツには一意に識別可能なように可視マーカがつけられれており,位置と方向を机上のカメラを通じて認識します.紙パーツの配置結果は,あらかじめ取り込みパーツ部分を除去して肌色で塗りつぶしておいた顔領域上に,配置され平滑化処理されます.

a) マーカーがつけられたパーツ b) 遊んでいる様子

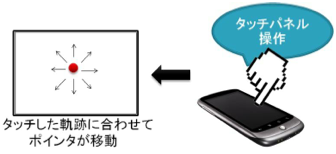

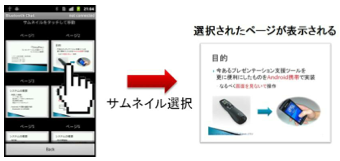

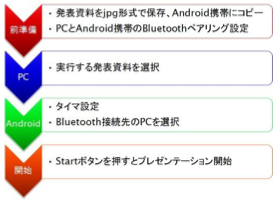

テーマ2:プレゼンテーション支援ツール for Anrdoid携帯

本テーマでは,スマートフォン(Android携帯)パワーポイントを用いたプレゼンテーションを支援することをめざしました.現在でもレーザーポインタにスライド送り機能が合体した製品が販売されていますが,本テーマではページ送り戻しや指示棒機能 (a) といったそれらに共通の機能に加えて,残り時間の通知(b)や特定ページへのジャンプ(c)などディスプレイとタッチ入力といった高機能なスマートフォンのUIを生かしたものとなっています.また,発表時の聴衆に与える印象も考慮して,誤タッチや端末画面の注視をしなくても済むような操作性を目指しました.あらかじめ,パワーポイント資料をJPEGで画像として保存して,Android端末側に保存しておくことで,サムネイルを見ながらスライドのジャンプを迅速に行うようにすることで,画面の注視時間を減らすようにしました.なお,本テーマの成果物は, 東工大・像情報工学研究所および(社)映像情報メディア学会主催のモバイルアプリコンテスト2012にて優秀賞を受賞しました.

(a) 指示棒 (b) 残り時間の通知

(c) 指定ページのジャンプ (d) 資料作成から使用までの流れ

2010年度

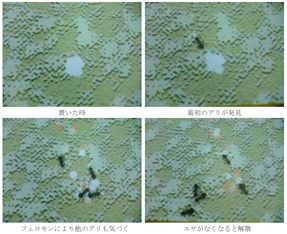

テーマ1:Interactive Ant: 拡張現実感を用いた仮想アリとのインタラクション

本テーマでは,プロジェクタで机上に投影されたアリの群れのアニメーションに,障害物を置いたりエサをやるといった現実世界で見られる操作を加えることで仮想世界と物理世界とのインタラクションを実現します.巣穴から出たアリはエサを見つけるとフェロモンを残して巣穴に戻ります.それを検知した他のアリが次々と集まりだし,やがて「仮想アリの道」ができます.この道は,障害物(カラー粘土塊)を置いてもそれを回避するように再生成されます.さらに,ルーペを置くと,ルーペ内部のアリの像が拡大表示されます.障害物や餌を載せたスプーン,ルーペは物理世界に存在する物体ですが,それらの種別や位置の特定はマーカーを使わずに物体そのものを認識することで実現しているので,より自然な状態を表現することが出来ます.

a) ハードウェア構成 b) フェロモンによる群れの生成

c) ルーペによる内部の拡大 d) 障害物の回避

テーマ2:SmartUmbrella: 便利傘

本テーマでは,既存の日常物に新たな価値を付加するというコンセプトに基づき,傘に知覚・出力(I/O)機能を付加しました.傘は持ち歩いていることが分かるように加速度センサと,携帯電話(Androidスマートフォン)との連携および携帯電話との距離を電波強度から推定するためのWiFiモジュール(シングルボードコンピュータ:PhidgetSBC)が搭載されています.

a) システム構成 b) ハードウェア構成

アプリケーションとしては,1)携帯電話を通じて取得した降雨予報に基づいて帯同を促すようにLEDを点灯させる「天気情報通知機能」,2)コンビニなどで傘立てに置いたまま去っていくことを防ぐ「置き忘れ防止機能」,3)傘の持ち主との携帯電話とのペアリングにより持ち主以外が持ち去ろうとする(ペアの携帯電話が付近にない)ことを防止する「盗難防止機能」を実装しました.

c) 置き忘れ防止機能の例(左:離れているとき,右:出口付近(仮定)に近づいたとき)

d) 盗難防止機能の例(左:ペアリングされている携帯電話とともに持たれたとき,右:ペアなしで持たれたとき)

2009年度

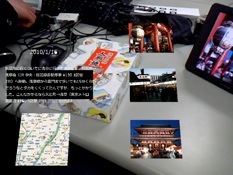

テーマ1:拡張現実感を利用した思い出管理・利用システム

旅先で買ったお土産(物理オブジェクト)や撮った写真(電子オブジェクト),イベント情報などを「時間」や「場所」で関連づけて管理しておき,ヘッドマウントディスプレイ(HMD)を通して,目の前のお土産に付加して提示しようというものです.

右図のようにお土産には,それを識別できるマーカーがつけられており,購入した時間や場所を関連づけることができ,コンピュータ上で管理することが出来ます.このお土産を中央にあるようなHMDを通じて見ると,その土産を買った場所の地図やそこで撮られた写真などが近くに重ね合わさった状態で見ることが出来ます.マーカーの処理と情報表示はARToolkit+OpenGLを利用しています.

a) マーカー付きの土産 b) HMD+Webカメラ c) HMDで見ている映像

さらに,マーカーをつけた手袋で特定の写真を指定して,それを同じくマーカーが付いたデジタルフォトフレームに重ねると(ドラッグ&ドロップ)そこに写真を表示することが出来ます.この操作はマーカー同士の位置関係で認識しています.

d) 制御用指マーカー e) 写真の選択 f) デジタルフォトフレームへの転送

テーマ2:インタラクティブな仮想ペットの実現

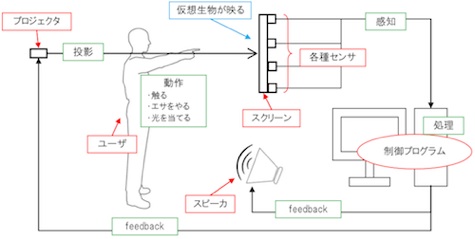

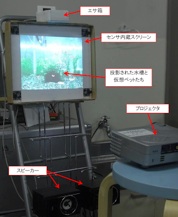

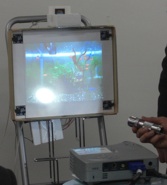

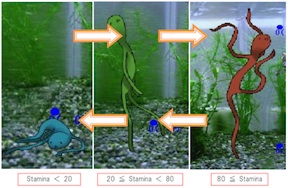

たまごっちのような仮想ペットは電子デバイス上に存在しますが,インタラクションの手段はボタンを押すような単純な動作に限られています.このテーマでは,仮想ペットが存在する物理オブジェクトをたたいたり,明るさを変えたりといった実世界で発生したイベントを入力として,仮想ペットを制御します.下図のように,プロジェクタを通じて水槽と仮想ペットの映像をタスクリーンに投影します.物理世界とのインタラクションを実現するために,タッチ位置を最大73分割して取得できるスクリーンを開発しました.同種の仮想ペットはBoidアルゴリズムにより自律的に群れを形成して移動しますが,スクリーンをタッチすると群れの形状が変化します.

a) 機能構成図

b) ハードウェア構成 c) 仮想水槽中の仮想生物

また,スクリーンの四隅にはライトで照らされている場所を検出するために光センサを配置し, RFIDタグが付いた「仮想エサ」を与えたことを検知するためにRFIDリーダーを配置しました.光を当てた場所にある「藻状生物」は長さによって活性度が変化します(d, e).一方,仮想エサが検出されるとえさ箱の近くに寄ってきて,体が大きくなったり分裂して数が増えたりします(f).

d) 照明によるインタラクション e) 「光合成」による生物の成長 f) 仮想エサによる成長・分裂

a) 機材