ロボットは動作をしながら、感情を伝えることができるのか?

ロボットは動作をしながら、感情を伝えることができるのか?

国立大学法人東京農工大学大学院先端機械システム部門 ベンチャー・ジェンチャン准教授、スペインのカタルーニャ工科大学のバサニエズ・ルイス教授とクラレ・ジョッセプアルノ研究員は、ロボットの動作の中に感情を表す動きを加え、人間に感情を伝えるための新しい運動制御方法を開発しました。また、この制御方法を使用し、実際に表現する感情が人間に伝わるか、感情の種類によって伝わり具合に違いがあるかを調査しました。これらの研究成果により、人間とロボットの共存を目指し、スムーズな意思疎通の実現やそのためのロボットの理解や開発が進むことが期待されます。

本研究成果は、International Journal of Social Robotics(1月17日付)DOI 10.1007/s12369-016-0387-2とSpringer Proceedings in Advanced Robotics(3月27日)DOI 10.1007/978-3-319-50115-4_69に掲載されました。

背景

現在のアプローチでは、ロボットがある仕事を行いながら、同時に身体の動作によって感情を人間に伝えることはできません。ロボットの動作によって感情を伝える方法は多数報告されていますが、これまでの方法では、ロボットの関節を用いて感情を独自の動きで伝えます。この場合、ロボットが決まった仕事をしながら、感情を伝える動作を行う必要があった場合、動作に制限が生じるため、与えられた仕事を行うか、それを停止して感情を伝える動作に切り替えるか、どちらかに決めなければいけません。

「人間のように、ある仕事を行いながら、同時に感情を伝える動作を行うことは可能でしょうか?」

本研究の目的は、ヒューマノイドロボットの身体動作制御を通じて、ロボットが人間に感情を伝えるための技術を発展させ、上記の質問に答えるための一歩を踏み出すことでした。

研究成果

仕事の優先順位の定式化は、ロボット「Pepper」で実装されています。そこで優先度の高いタスク(手を振る、物を運ぶ、など)を指定し、人間に感情を伝えるタスクについては優先順位を下げて実施します。本研究では、アメリカの心理学者であるアルバート・メラビアンによって定義されたPleasure(快)-Arousal(覚醒)-Dominance(優越)モデルから感情を変数化し、3種類の動きの特徴(ジャーキネスと呼ばれる動きに加わる「揺れ」、「活発さ」および「視線」)で表現しました。そしてこれらの動きが人間に感情を伝えているかを調査しました。

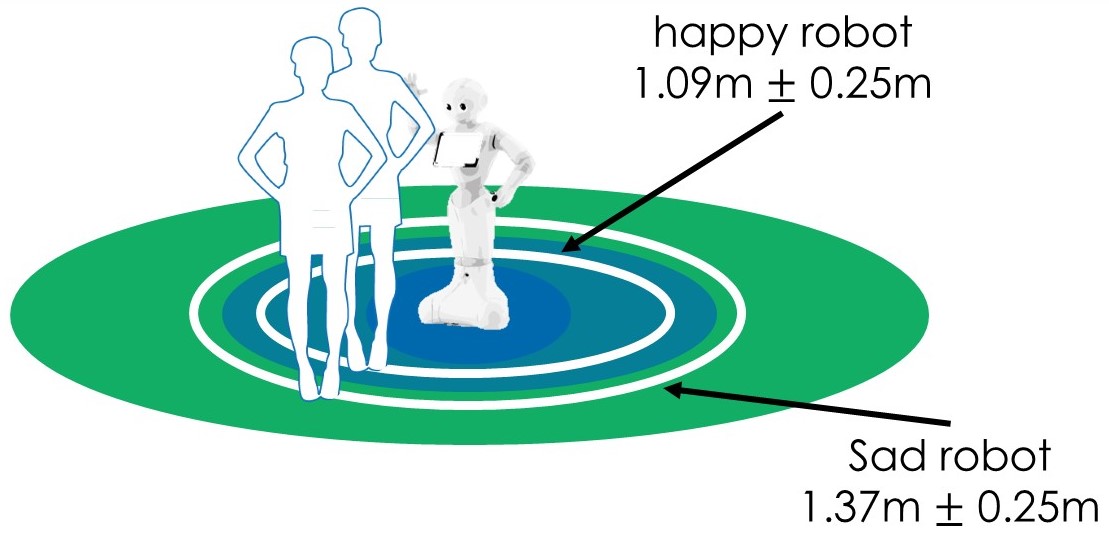

また、人間は感情を知覚して対象との適切な距離をとりますが、ロボットの感情的な動きがその決定に重要であるかどうかを検討しました(図)。 この実験では、参加者に、“恐がっている”、“悲しそうな”、“嬉しそうな”、または中立的な状態“平穏”を伝えているロボットから、①机に座ってアンケートを記入すること、そのあと②好きなだけロボットに近づくことの2つの指示が与えられました。

結果から、“嬉しそうな”と“悲しそうな”ことが参加者に伝えられていることがわかりました。次に“平穏”がよく伝わっており、“恐がっている”ことはうまく伝えられていませんでした。設定した動作と参加者が知覚する感情との関係を分析すると、運動の活発さは「覚醒」と正の相関を示し、ジャーキネスは参加者によって知覚されず、動作があまり活発でないときには視線が「優越」を伝えていました。また、参加者が“嬉しそうな”ロボットと“悲しそうな”ロボットに対して取った距離(右図)は、人間と人間の間に認められるものと同様でした。

今後の展開

今回の成果は多くのロボットや動作システムへの応用が可能と期待されます。たとえば近い将来、人間とロボットが日常的にやりとりをする場合です。いくつかの研究では、生産性と労働者の感情状態との関連性が示されています。例えば、幸福感は生産性を上げ、一方で不安は認知能力を損なうことで、疲労と生産性の低下につながります。ロボットは、作業者が仕事を成功に導くために、適切な感情状態を人間に伝えることが必要になるでしょう(たとえば、ロボットが人間の方に壊れやすい荷物を運んでいるときの“落ち着き”、または狭い通路でロボットと人間が協調して繊細な物体を運んでいる状況での“覚醒”)。

人間に感情を伝えることに関心がもたれる別の状況として、例えば、ケアロボットが物を運んでいるときに、患者の気分が落ち込んでいると感じて、ポジティブな感情を相手に伝える場合があります。今後、ロボットが人間により受け入れられるように、適切な感情を伝達することも可能になります。また、発言中に手で身振りしているロボットにとって、音声の感情的な内容を補完できることは興味深く(そして必要であり)、手がジェスチャーに使われている場合でも可能となることは重要です。また、リアルタイムでロボットの感情を変えることでユーザーの感情状況をフィードバックすることも可能になると期待されます。

参考情報

本研究の内容について、以下のとおり、ベンチャー・ジェンチャン准教授による講演を行います。

<講演詳細>

・日 時:2017年11月10日(金) 19:00~20:30

・会 場:三鷹ネットワーク大学(東京都三鷹市)

・テーマ:「Human Motion Analysis & Robotics~感情認識とロボット工学の試み~」

・定 員:30人(先着制)

*三鷹ネットワーク大学天文・科学情報スペースにて、企画展「ヒトとロボット 未来のカタチ」も開催します。(会期:11月10日(金)~12月24日(日))

*詳細は、以下のサイトをご参照ください。(別ウィンドウで開きます)

https://www.mitaka-univ.org/kouza/C1753100

◆研究に関する問い合わせ◆

東京農工大学大学院工学研究院 先端機械システム部門 准教授

ベンチャー・ジェンチャン

e-mail:gvinfo(ここに@を入れてください)cc.tuat.ac.jp